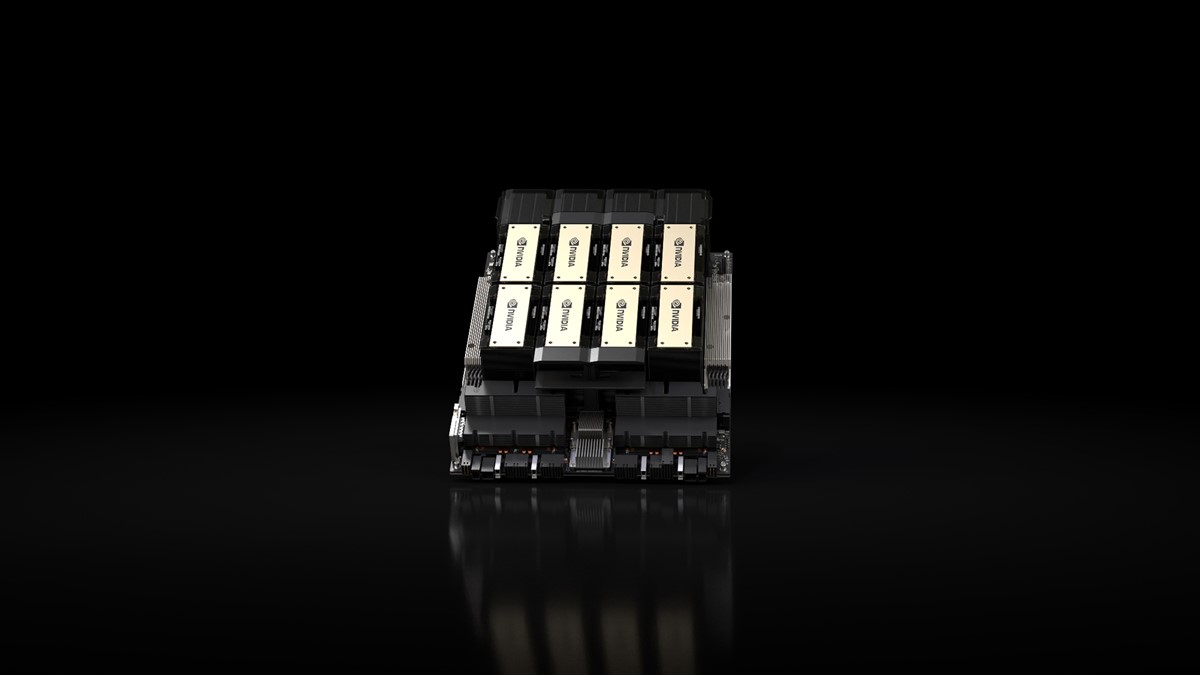

Nvidia lansira novi AI čip HGX H200

Kako bi se omogućio brži rad s generativnim AI i LLM-ovima HGX H200 koristi novu, bržu memorijsku specifikaciju nazvanu HBM3e

U pitanju je nasljednik čipa H100 koji uz HBM3e specifikaciju isporučuje 141 GB memorije pri 4,8 terabajta u sekundi, gotovo dvostruko veći kapacitet i 2,4x veću propusnost u usporedbi sa svojim prethodnikom, Nvidia A100.

Sve to s ciljem povećanja njegove sposobnosti da se nosi s intenzivnim generativnim radom umjetne inteligencije.

H200 će također biti kompatibilan sa istim sustavima koji već podržavaju H100 tako da pružatelji usluga u oblaku neće morati raditi nikakve promjene prilikom nadogradnje na H200.

“Integracija brže i opsežnije HBM memorije služi za ubrzavanje performansi u računalno zahtjevnim zadacima uključujući generativne AI modele i aplikacije [računalstva visokih performansi] uz optimizaciju korištenja i učinkovitosti GPU-a,” rekao je Ian Buck, Nvidijin potpredsjednik za računalne proizvode visokih performansi, u video prezentaciji.

Prvi H200 čipovi će biti objavljeni u drugom tromjesečju 2024., a Nvidia kaže da surađuje s "globalnim proizvođačima sustava i pružateljima usluga u oblaku" kako bi ih učinila dostupnima, navedeno je u objavi.

Što se toga tiče Amazon, Google, Microsoft i Oracle će biti među prvima koji će sljedeće godine ponuditi nove GPU-ove u svojim cloud uslugama.